目前IDC机房建设规模越来越大,服务器的集成度越来越高,数据设备的功率提升和其部署方式带来了新的冷却问题,这使得IDC机房内的制冷空调问题,已经超越电源,成为电信运营IDC的首要问题。文中针对IDC机房空调存在的主要问题进行分析,提出解决方案并对部分方案进行了实际应用。

目前IDC空调存在的主要问题

从目前IDC运行情况来看,IDC机房空调电源中断、空调冷量设计、机房大环境气流组织不合理、机柜内部小环境气流组织不合理、机柜热量过大、机柜布置不合理等问题是导致机房过热的主要原因和问题。对这些问题,本文从电源保障、空调配置、气流组织和高密服务器布置等方面展开探讨,提出解决方案,并在杭州IDC机房建设中进行了实际应用,在保障IDC机房安全运行同时,达到节能减排的目的。

空调保障解决方案

1空调电源保障

IDC机房内发热厉害,温度梯度变化也大,通风降温复杂,而空调使用的是市电,一旦停电,就会造成机房温度迅速窜升。在一般的通信机房,由于功率密度低,柴油发电机启动延迟和常规的电源倒闸操作是没有问题的,但是对IDC机房来说,在电源中断的这段时间内是难以接受的,空调会停止制冷,特别是空调风机的停机导致了气流循环的中断,据测试,在单机柜5kW负载情况下,机房温度会在发电机启动延迟和电源倒换过程中会升高5~20°C;如果电源中断时间过长,就会演变成为一场灾难。可见,保障IDC机房空调的电源可靠性和提升可用性是重中之重,必须制定可靠的空调电源保障方案,以防止空调电源中断或尽量缩短电源中断时间。

1

UPS方案

由于空调的重要性,大负荷IDC机房空调的供电等极应不低于服务器设备的供电等级,因此采用UPS供电也并不为过。在国外,大型数据中心的机房空调系统采用UPS供电的方法越来越普遍;在国内,江苏电信公司部分机房把专用空调的风机接在UPS上,这样解决了停电后的短时间气流组织中断的问题,从使用效果来看还不错。采用UPS方案不利的因素是存在投资过大的问题。

2

IDC空调双电源方案

对IDC机房,同一个机房的空调电源最好不要同时使用同一路电源,以防止一路电源中断就会导致机房温升过高。IDC机房的空调配电屏,进线电源必须有两路,两路电源必须来自不同的低压配电系统,两路电源间可以手动切换或者采用ATS自动倒换,如果采用ATS最好设置成不同的主路(但是在油机供电下,要注意ATS的自动切换可能会引起部分油机的过载);一旦电源中断,可以缩短中断时间并减小影响面。图1、图2和图3是杭州电信IDC普遍使用的双电源屏和双ATS电源屏。

3

空调配电屏接线方法

相临的空调应该从不同的空调配电屏引出,如1个机房布置16台空调,两块空调配电屏,那1、3、5、7等奇数空调就从配电屏1引入(主用市电1),2、4、6、8等偶数空调从配电屏2引入(主用市电2)。这样即使一路电源发生异常,影响到的空调是部分的,恢复的时间也很快。

4

双ATS电源柜+空调新型电源接线方法

这种方案是对方法2、3的综合应用,即采用ATS的同时采用双电源屏方案。从实际使用效果来看,在两路高压引入的情况下,采用双ATS电源柜+空调新型电源接线方法,比用UPS供电更经济,而且可靠性也没减少多少,由于同一机房的空调电源来自于不同的高压系统,如果这两路高压是真双路的话,那同时停电的概率是很低的;而在停一路高压的情况下,还有一半的空调在运行,最重要的是气流组织不会中断,在油机启动倒电过程中机房的温升还是可以接收的。一个大的IDC机房最好有两块以上的空调配电屏,以方便上述方法的空调接线,如果仅采用一块空调配电屏,空调配电屏内部的空开要有备份和冗余。

2空调配置

机房空调的冷量要大于机房的最大热负荷并有富裕,空调的配置原则是根据机房总热量总体规划空调设计,按照N+1原则配置空调数量。可是我们会遇到这样一个问题:空调已经按照N+1配置,为什么IDC机房温度会打不下来?

1

分区配置原则

传统的配置是以机房为单位;采用的是房间级制冷,空调是以机房为单位进行制冷,但这种方法的配置和冗余并不适用于大型的IDC机房。

现在的IDC机房由于建设规模大、面积大和机柜功率密度高,如果按照房间级配置空调,一台空调发生故障,由于冗余的空调相距过远,气流组织无法送达,会造成局部机柜设备过热;因此大型IDC机房的空调要进行分区配置,即把一个大型的IDC机房划分为若干个分区,然后保证每一个分区内的空调均有冗余,这样空调发生故障后,每一块区域内的服务器才是安全的。杭州电信的兴议、滨江等IDC机房,就以四列的机柜为一个分区,然后按照每个分区都满足N+1的冗余方式配置,是一种比较安全的办法。

2

空调冷量取值

机房空调的冷量计算要采用显冷量,而不是空调全冷量。要保证机房空调的总显冷量始终大于机房的热负荷,但是机房空调的显冷量在不同情况下是一个变值,它标注的显冷量是在23度、50%下测定的,随着机房湿度的增高,机房空调的显热比会下降。比如一台制冷量标注100KW的机房空调,测试工况下显冷量90KW,当机房现对湿度达到65%以上时,空调的显冷量只有80KW了,20%的冷量消耗在除湿过程中。设计过程中如果按90KW或者100KW的数据设计,夏季高温高湿环境下,机房的冷量就会不够。另外在较大的IDC机房里面,由于混风情况的存在,导致空调的送回风温差过小,空调显冷量进一部下降。因此在确定空调的制冷总容量时,必须加大30%以上,目前的经验认为,空调的总制冷量必须是机房热负荷的1.3~1.6倍,大型的IDC必须取上限。

3

合理的N值

从IDC运行情况来看,N+1的N数值要合适,N大了,冗余度不够,机房不安全;N小了,机房会安全,但投资大且造成空调运行的能效比过小,如果采用冷备用空调(停机),部分冷风也会从停机的空调回风口跑出来,造成气流短路或者气流倒灌,影响机房的原有气流组织,如果能够以低速或者低风量运行备用空调,那总体风机功率就可以下降,效率提升;IDC机房空调的N取值在4~5之间是比较合理的,更高密度机房则要把N取值再减低。

另外对于部分新建和扩建机房,由于负荷的不确定,空调无法一部安装到位,是随设备的增加而陆续增加的,这种情况要统一规划好空调的位置,并跟踪机房热负荷变化情况,适时增配空调,确保机房始终满足N+1原则。

空调配置多,可以提高机房的安全性,但会降低空调的能效比,导致耗电上升,如何以较少的备用机房空调在高密度机房情况下实现冗余是我们机房空调运行中必须关注的一个问题。

3机房大环境气流组织

这是IDC规划和设计的重点和难点,气流组织的产生、气流组织的配送和气流组织的返回都要合理,一个高效有着良好气流组织的IDC机房是规划和设计出来的,而不是靠后期改造出来的。对于一个新建的IDC,从有利于气流组织的角度出发,下面这些是必须注意的。

1

机房布置

大型IDC机房不宜为正方形,而应为长条形,这样有利于空调布置,并减少空调的送风距离和风阻。

2

送风方式

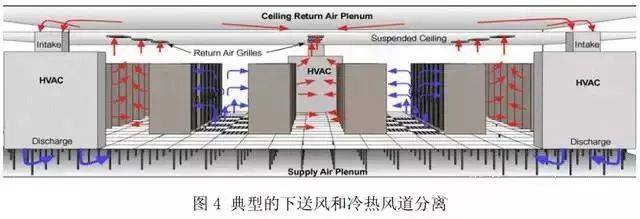

新建的IDC空调应该是下送风方式,冷热风道进行分离。

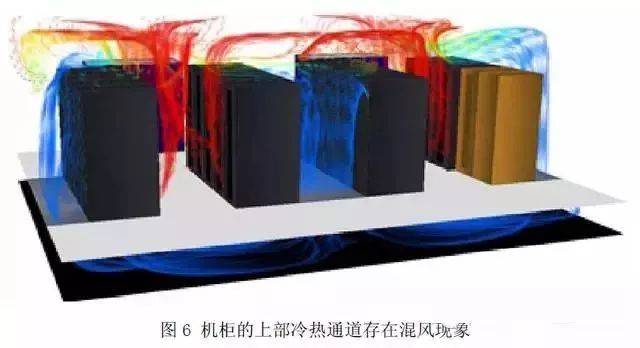

目前的送风方式有上送下回、侧送侧回、上送上回及下送上回等多种方式,但是下送风方式比上送风更有利于机房的气流组织和提高送风效率,如图4;冷热通道分离是指各个机柜服务器均以面对面,背高背的方式进行布置。冷热气流组织隔离后气流组织更合理,而且增大送风和回风之间的温差,从而提高机房空调机组的效率。目前的研究表明,达到相同制冷效果的前提下,下送风所需风量比上送风所风量小,这也就说明了下送上回式风比上送下回气流组织效率更高。

3

关注地板高度、楼房的净高和机架间距

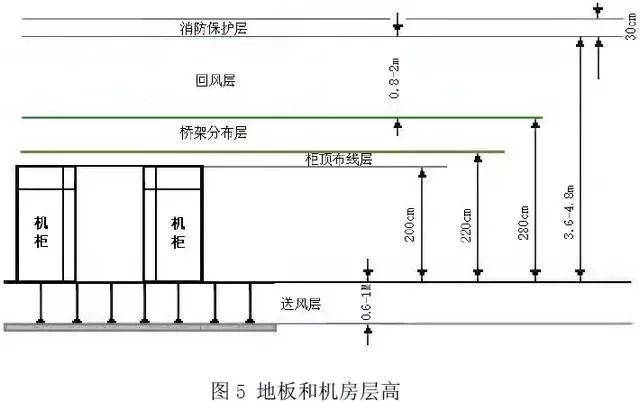

活动地板的高度对机房空调的空气循环效率有着重大的影响,架空地板的高度应根据负荷密度、机房面积综合确定。所需的净高度取决于机房的大小功率密度和空调的设计方案,对于气流组织来说,活动地板高度是越高越好,大型IDC机房建议地板净高≥60cm(图5),并根据机架负荷可以适当加大机架间距。

IDC机房的高度不宜太低,要保证回风层的层高,如果这个高度如果太低,会影响空调的回风效果,导致机柜内部的热量不容易返回到空调,另外在市电中断过程中,机房层高也会影响到服务器宕机的时间,因此要保障机房的层高,图4是建议的机房高度。

4

风道完整

要保证冷风道的完整,这样才能保证气流组织,常规的解决措施如下:

封闭地板上所有不必要的开口,包括未安装服务器的机柜、UPS电源和空调电源柜等下部的开口,防止冷风风道气流泄露;

靠近墙面和电缆井的地方也需要进行封闭。

实际使用中,如果发现机房某处的温度明显过低,就表明该点的附件存在冷风泄露,要找出泄露点并进行封闭。

5

开口地板的布置

开口地板应该布置在需要冷风来对设备进行冷却的位置。不要在机房空调机组附近放置开口地板,否则空调送出的冷风很容易返回到空调,开口地板与空调机组之间应保持至少2m的间距。

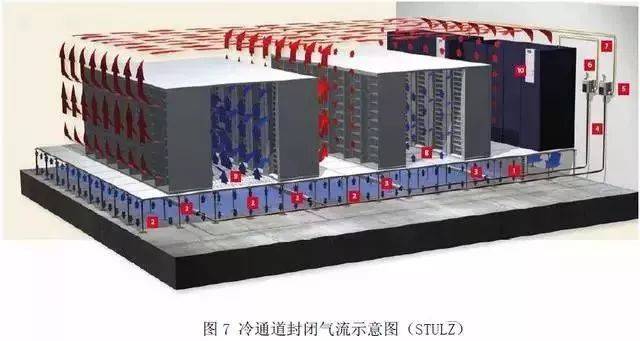

冷通道封闭

各机柜以面对面成排方式布置,在冷通道上机柜的顶部和整列机柜的两端进

行封闭。这样送风和回风之间就实现了完全的隔离,冷风通过活动地板送到密闭的冷通道内,热风离开机柜进入机房环境,再返回到机房空调机组(图7),机房本身处于一个较高的温度水平。

要注意的是整个IDC机房内的所有冷通道都必须被密闭,这样才可以体现封闭的优势,仅仅封闭机房内的部分冷通道没有太多的作用和意义,因为在没有封闭的地方,跑出的冷风都可以与热风混合从而抵消预期的节能效果。封闭冷通道后,空调的送回风温度均可以提升,使制冷系统运行在高效情况下面。

但是在实际运行情况下,冷通道被封闭后,机房其余的空气温度会变得更热了(在27℃~35℃),在这种高温下,用户会以为是空调发生故障,即使事先沟通,知道该情况机房空调未发生故障,进入机房巡视的人感觉也会很不舒服,因此要和用户充分沟通,让他们认识并接收这种观念。否则用户就会要求降低空调

设置温度,这样一来,节下的能量又回去了。

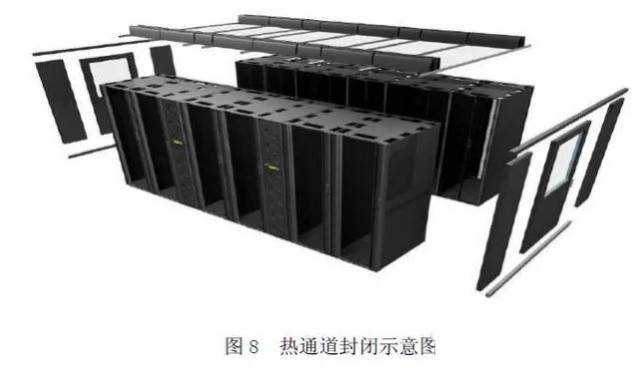

热通道封闭

各机柜以面对面成排方式布置,在热通道上机柜的顶部和整列机柜的两端进

行封闭,以管道或者天花板的形式把热风引会到空调机组内,这样送风与回风之间也实现了隔离(图8)。

由于冷风送到整个机房,机房处于一个较平均的温度水平,而热通道能够保持较高的温度。现有资料显示:在典型的高热机房中,服务器热风和机房室温的温差一般在17℃左右。如果机房温度按ASHRAETC9.9要求保持在22℃,那么17℃的温差可以使服务器的排风温度达到39℃。但在实际的热风封闭系统中,制冷机组的送风量往往会比服务器需求量要多,而且会有少量的机房空气进入热通道,这样导致回风温度略有下降,但仍然达到38℃,这样高的回风温度使得与制冷盘管的热交换更充分,制冷设备利用率更好,总效率也更高。回风温度的提高对制冷机组制冷量的影响适用于几乎所有的空调,所有的制冷系统在回风温度较高时都将具有更大的制冷量。

通道封闭需要考虑的因素

通道封闭会增加建设成本;在机柜的前方和后方安装密封盲板均会增加成本。

通道封闭会造成回风温度升高;密封越好,空调的回风温度越高,要关注空调设备和用户工作环境温度的运行限制。

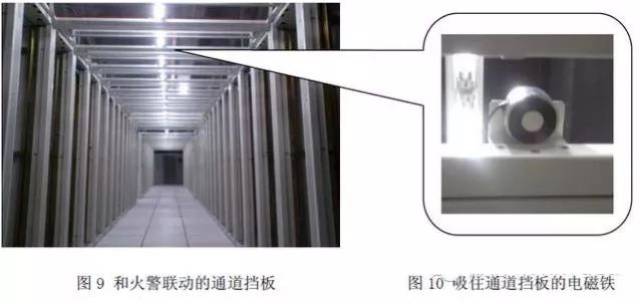

通道封闭要不影响到现有的消防系统。在对冷热通道封闭的过程中,会对消防系统产生影响,一旦火警,消防气体不容易进入封闭的通道内,影响消防系统的使用,针对这种情况,杭州电信的技术人员在东冠IDC中心采用了可以自动敞开的柜顶(图9),在柜顶安装有电磁铁(图10),正常情况下,电磁阀线圈得电,吸住柜顶挡板;电磁线圈和消防联动,一旦火警,电磁线圈失电,柜顶挡板在重力作用下自动打开,冷通道从封闭模式变成敞开模式。

这样做带来两个好处,一是解决了消防的问题,另一个是和市电联动,在市电中断过程中,敞开的通道可以延长服务器的宕机时间。

机柜内部气流

对于服务器来说,如果空调总的制冷量和机房大环境气流可以满足机房要求,最后还要保证机柜内部的服务器的温度正常,换句话说就是机柜内服务器产生的热量要能通过机柜内部的小气流组织及时带走;在机柜里面,一方面,空气气流会选择流阻最小的路径,我们要阻止机柜内热空气同冷空气混合,另一方面,在一个机架内,冷气是从下部送入,自下而上流动,机架最上部服务器温度往往是最高的,如果机柜内部的小气流组织不合理,或者冷风进风量不够,就会造成服务器局部过热。

消除气流回流

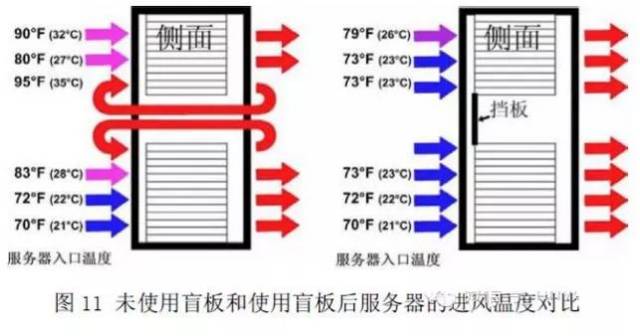

在气流回流存在的情况下,机架正面的垂直温度梯度会很大,部分机架前部的上下温度差可达10°C。因此要使用盲板或挡板来封闭服务器被拆除或者未安装的空间,防止部分冷空气直接跑到热风风道内,另一方面也可以防止服务器的热风通过这些部位回到服务器的冷风风道内,造成气流组织短路。。安装挡板可以防止冷却空气绕过服务器上的入口形成热空气循环,在机柜上层服务器的入口温度有了明显下降,图11美国电力转换公司对安装盲板前后的服务器进风温度对比情况。

新型工艺机柜

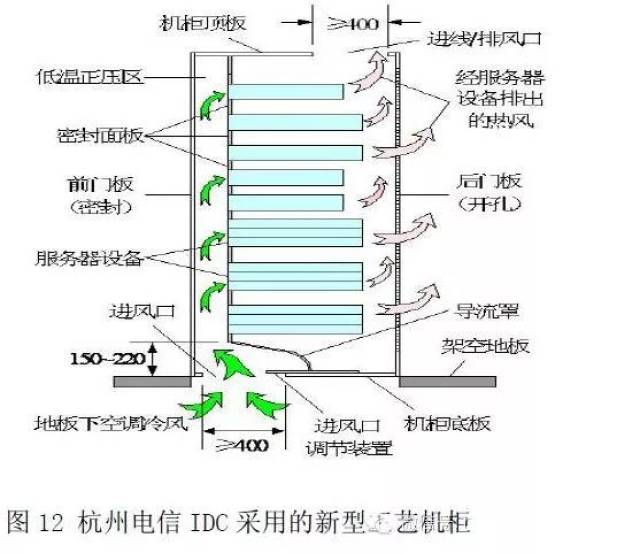

这种机柜是专门对机柜内进行优化和机柜气流组织设计,直接在机柜内部进行送风,采用盲板和漂浮式盲板来封闭机柜上未使用的单元,机柜的前门和服务器形成一个单独的冷通道,热风从机柜的后面和上端排出,避免了机柜内气流短路,气流组织比较合理。根据这个原理,浙江电信分公司在2008年专门研制了新型工艺机柜,并在杭州电信的IDC机房进行应用,如图12,在单机柜功率4KW情况下,这种机柜冷却良好并起到很好的节能效果。

更高密度服务器布置

在IDC运行情况看,我们会遇到两种不同的热点问题,一种是在高密度区域布置更高密度服务器造成的局部温度过高,如在平均机柜5KW的机房布置10KW以上的机柜;另一种是整体热点问题,一个机房的所有服务器均是高密度设备,如单机柜平均功率10KW以上,造成整个机房温度过高问题。对于前者,最好是不要这样布置,如果逼不得已,那最好能采取一些特殊的补救措施;对于后者,建议重新设计IDC机房。

1局部更高密度布置方案

不同功率密度的服务器不宜布置在同一机房,尤其是在固定密度区域布置更高密度服务器,会导致机房局部热点问题突出。但在实际过程中,往往又不可避免,比如用户一定要这样布置,而沟通无效的情况,如何解决这些问题?

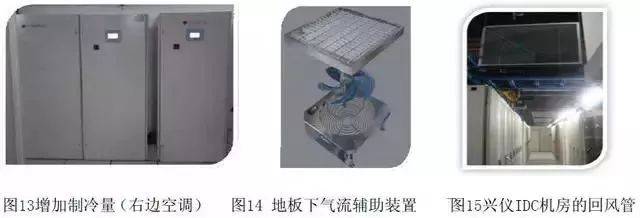

方法一:在现有的运行空间内加强冷却能力

如果用户无法对他的高密度服务器进行分散,这种情况下,就要想办法增加冷却能力,如杭州电信就在机房里额外增加了部分空调(图13),并在高热区域增加开口地板数量,也可以安装地板下气流辅助装置(图14),个别机房安装了特制的回流管道(图15),确保高密度服务器可以得到足够的冷量,同时服务器排出的热量可以顺利返回到空调。

方法二:分散高密度机架

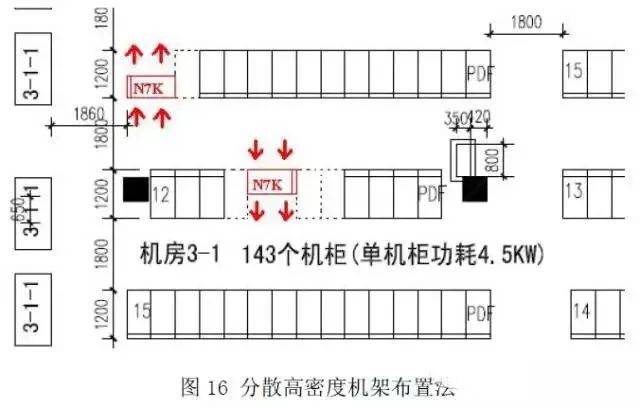

但在实际情况中,由于机房空间的限制,增加空调冷量的方法很难实现,因此将高密度负载进行分散是一个比较有效的方法,这样分开的高密度机架可以有效地“借用”邻近机架的冷量来进行冷却。杭州东冠IDC机房,用户要在机柜设计功率4.5KW的机房放置部分12KW的核心网络设备(ciscoN7K),在解决这个问题时就采用了热量分散原则,将两个机架布置在不同的两列,并留出三个机柜的位置用来冷却这个高密度机架,这样机房平均功率密度控制在设计的范围内,如图16:

2整体高密方案

如果所有服务器均是高密设备,必须重新设计IDC机房,但是我们会面临一个问题,就是风冷空调的冷却极限(目前在6kW/㎡),如果机柜的发热过大(现在一个机柜的热量就轻松突破20kW),我们应该如何解决这个问题呢?

采用增加机柜的间距或者减低服务器的放置密度,从而降低整个机房的平均功率密度,可以把功率密度控制在风冷极限的范围以内。在杭州电信滨江IDC机房,某服务器单机柜铭牌功率20kW(图17),实测13kW,机柜发热严重。而用户又很着急,为了完成这个任务,杭州电信在规划这个机房时,加大了冷风道和热风道的间距,将冷风道从1.2米提升到4.8米(图18),并增加了热风道的间距,这样一来,单位功率密度就下降了一半;另外增加了机房空调数量,空调的冷量采用了2N配置;同时提升了地板高度,把地板高度提升到1.2米,并启用了栅栏地板,保证了机柜所需的冷风风量。

从使用效果看,该机房冷却效果良好,圆满地解决了用户的需求。但是这种解决方案存在投资成本过高的问题,这种解决方法在对成本不敏感的情况下使用才是合理的。

总结

END

以上对IDC建设和运行一些比较容易遇到的主要问题进行交流探讨和摸索,或许上面提到和采用的方法并不一定是最好或是最完善的,但希望这些做法可以给同行借鉴和参考,避免走弯路和减少不必要的浪费,IDC的系统设计、建设和运维,还有很长的路要走;对目前广泛普及的高密度机架进行冷却还有待我们的探索和经验积累;另外IDC的节能降耗,也是任重道远的任务和工作。希望在以后的日子里,大家齐心协力,促进电信IDC的发展,并为IDC的节能减排贡献自己的一份力量。

参考资料

1、中国电信数据中心机房电源、空调环境验收规范

2、GB50174-93中华人民共和国国家标准电子计算机机房设计规范

3、John Niemann热通道气流遏制与冷通道气流遏制

4、Neil Rasmussen在低密度数据中心部署高密度区域

5、Neil Rasmussen计算数据中心的总制冷量第一版

6、FIPS PUB94 "Guidelinefor Computer Powerfor ADP Installations";National Technical Information Service

7、STULZ数据中心制冷最优方案白皮书2008年4月第二版

8、中国电信股份有限公司浙江电信分公司新型工艺机柜的研制

文章来源:机房空调 /vertiv/